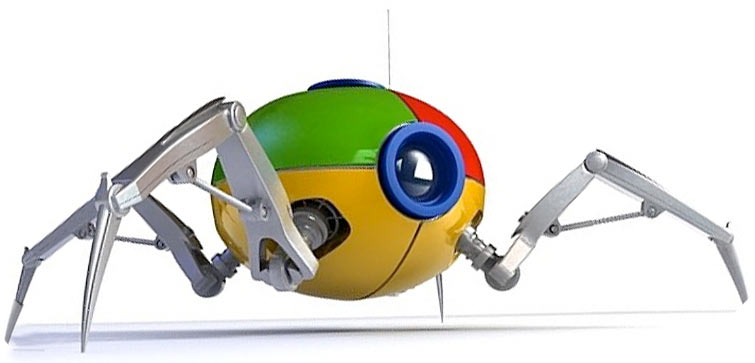

Todos los buscadores disponen de unos ordenadores que se les llama robots (o spider, araña en inglés) que se dedican a rastrar todas las webs que encuentran recogiendo información buscando contenido útil para incorporar en sus bases de datos.

Los robots o arañas de los buscadores como Google son procesos que recorren continua e incansablemente toda la web. Siguen prácticamente todos los enlaces que aparecen en las páginas web con el objetivo de obtener información relevante en base a distintos algoritmos secretos.

Frecuencia de paso de los robots

En la actualidad existen tanta cantidad de páginas web que los robots no pueden detectar cada cambio o modificación que se produzca en cualquier página web. De modo, que pasan por los sitios web en una frecuencia determinada que viene determinada por la popularidad del sitio. Google y los demás buscadores están mucho más pendiente de una página web que genera miles de visitas diarias que uno que sólo genera 2 o 3 visitas cada día. Esto lo he experimentado en la web de energía nuclear, que se actualiza muy rápido y en la web de Bruce Springsteen (con el SEO muy poco trabajado y que apenas tiene visitas) que tarda semanas en actualizarse.

Este es el motivo por el cual cuando hacemos un cambio en la web (un título o una descripción) no se ve reflejado en los resultados de búsqueda hasta cierto tiempo.

Cuando hacemos un experimento SEO incluso cuando ya nos ha visitado el robot de Google, puede tardar días o semanas en verse afectado por el posicionamiento. Cómo durante este tiempo es posible que hayamos hecho otras acciones SEO nos será difícil saber con exactitud qué experimentos han funcionado mejor que los otros.

Es muy importante que nuestra página web esté disponible todo el tiempo posible, dado que si los robots intentan acceder a ella y la encuentran bloqueada ni insistirán ni esperarán, quizá vuelvan a nuestro sitio un mes después y para nosotros será un tiempo perdido.

Además, pocas veces te habrás encontrado que el enlace de un resultado de búsqueda de Google no funciona, ¿verdad? Pues bien, cuando Google no puede acceder a una página suspende temporalmente su posicionamiento y no la muestra en los resultados de búsqueda. Más tarde lo vuelve a intentar y si ya está disponible quita la suspensión. Si, finalmente pasado un tiempo largo (semanas o incluso meses), la página web sigue sin funcionar la elimina de su base de datos.

Cuando realizamos una búsqueda en el buscador, en realidad, lo que hace es buscar en la base de datos que han ido creando sus robots con sus algoritmos secretos.

Los algoritmos de los buscadores

Los algoritmos de búsqueda están en constante evolución, son el secreto mejor guardado y el más deseado para los profesionales que se dedican al SEO y al posicionamiento web. Podemos intuir cómo funciona pero nunca estar seguros de su verdadero funcionamiento.

Cada buscador tiene sus propios robots o arañas y sus propios elementos para determinar el ranking y la posición en que debe mostrar cada uno de los resultados encontrados. Se podría dar que una determinara acción mejorara considerablemente el posicionamiento de una web en Google, pero no lo hiciera en Bing, o viceversa.